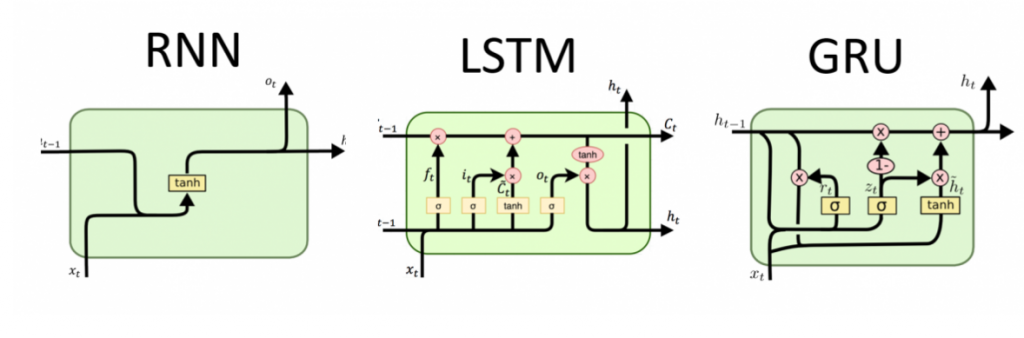

RNN LSTM GRU

为什么要把三个列在一起,因为它们之间从左到右进阶的关系,最开始大家用RNN,发现问题,提出方案就有了LSTM,同样方式就有了GRU。

RNN在时间跨度够长,就会有一个梯度消失,或者梯度爆炸的问题,因此人们在加入了一个遗忘门的概念,目的是就是定期去删除以往的记录。在LSTM中由于输入门,输出门和遗忘门,太过复杂,复杂意味着计算量大,训练难度的增加,因此有人提出了新的模型GRU,把输入门和遗忘门合并成一个门 – 更新门。

至于RNN LSTM GRU内部是怎么工作的,这里不讨论。这里只是简单解释为什么会存在这几个非常相似的模型。